赞

赞

欢迎关注百家时评,为你解读国际风云、财经要闻,洞悉全局,你值得加入!

如您在使用平台过程中有什么问题?可以扫描左边二维码添加客服微信咨询。也可以通过下方输入框进行留言。

日常生活中,我们在使用电器、电子产品时都知道一个常理:带电设备不能直接与水接触,容易导致短路发生火灾等危险。

然而在科技含量非常高的高尖领域,工程师却反其道而行之,将数十万、甚至近百万台服务器“泡在水里”来散热。

你不信?

近日,阿里云就宣布部署了全球最大规模的浸没式液冷服务器集群,通过将服务器“泡在水里”的方式进行散热,可为数据中心节能70%以上。

这是什么神操作?难道不会出现腐蚀电子元器件、设备短路引发大火的情况吗?

当然不会,今天给大家科普下浸没式液冷服务器基础知识。什么是浸没式液冷服务器?

浸没式液冷服务器,是把服务器整体浸泡在沸点低(35℃左右)、绝缘、无腐蚀性的特殊液体里(有的是特殊的油、有的是氟化液),以液体为媒介把服务器中CPU、内存条、芯片组、扩展卡等电子器件在运行时所产生的热量通过冷热交换工程设计带走。

而传统服务器则采用风冷散热,通过数据中心里的空调,对IT设备降温,降低数据中心(含单机服务器)内部温度,从而保障设备不会因温度过高发生意外(比如CPU过热导致宕机)。

举个更好理解的例子,浸没式液冷像我们用“热得快”直接插在暖瓶里烧水,没有任何隔阂的加热;也像夏天时,我们通过淋浴直接为身体降温,而不是依赖下雨先让空气温度降低,我们再感觉凉爽。

哪种散热方式效率更高、更有效,一目了然~

目前市场中主要有两种形态的液冷服务器,一种是浸没式液冷服务器;第二种是板式液冷服务器。

板式液冷服务器与浸没式液冷服务器最大的区别是,发热量最大的部件CPU不直接与散热液体接触,而是通过将液体灌输在传导设备中,CPU端与液体传导设备贴在一起,热量通过传导设备带走,从而达到散热效果。目前全球采用板式散热方式的相对多一些,因为该技术对比浸没式液冷服务器要解决的工业难题、成本都更低一些。

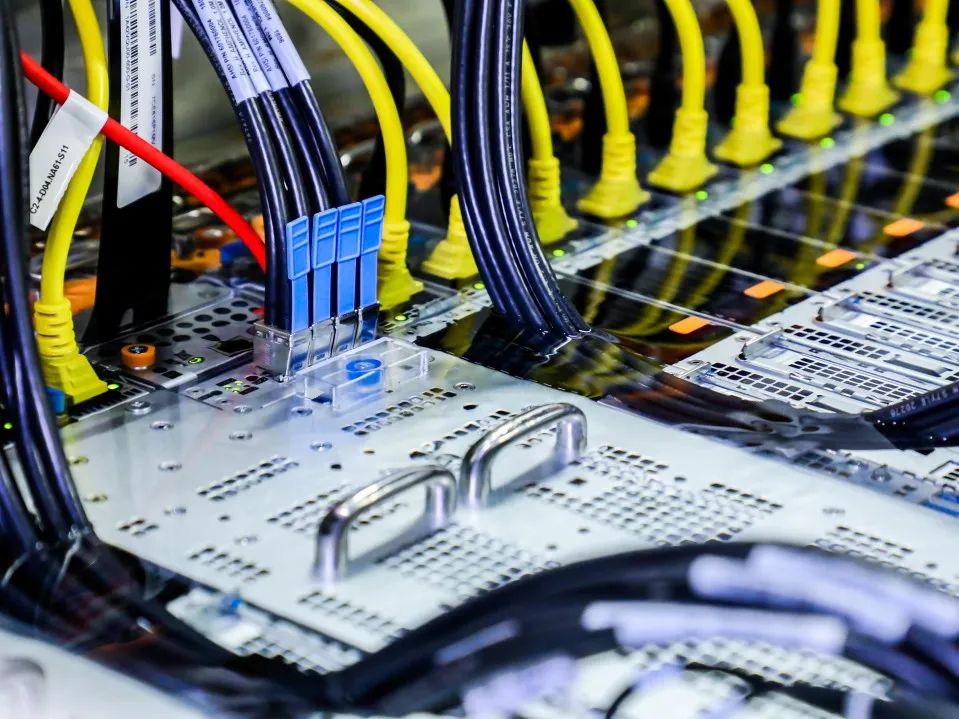

☉图片中黄色铜管连接CPU的就是采用板式液冷散热

☉阿里巴巴浸没式液冷服务器,交换机、服务器全部浸泡在冷却液中

浸没式液冷服务器担起“定海神针”角色

浸没式液冷服务器能担起数据中心“定海神针”一角,主要凭借PUE(电源使用效率)、TCO(总拥有成本)这两项关键指标领先传统风冷、水冷服务器。

PUE英文全称为:Power Usage Effectiveness(电源使用效率),是评价数据中心能源效率的指标。PUE数值是数据中心消耗的所有能源与IT设备消耗的能源的比值,国际标准化组织发布ISO/IEC30134-1标准,PUE被称为数据中心的“关键性能指标”。PUE值越接近1.0,表示数据中心的能效越好,绿色化程度越高,也就是越节约电力。

其实数据中心是电老虎,有数据显示,仅在2015年,全国数据中心的耗电量就高达1000亿度,年耗电量超过全社会用电量的1.5%,相当于整个三峡水电站一年的发电量,比水泥产业产能全开占全社会用电还多。

消费者每一次在淘宝购物,每一次刷微博,每一次在优酷看视频时,数据中心里的服务器都在计算我们的需求,同时消耗电能。

为了降低PUE,国际上很多大型企业也是使出各种招数。比如微软将装有服务器的圆柱形集装箱沉到海里降温、FaceBook将数据中心建在北极圈、甚至还有公司将数据中心放在北约曾经存储弹药的地下山洞里。

这么做的核心目的就是为了降低电能的消耗,节约IT运营成本。

☉微软将数据中心集装箱沉到海里

☉微软将数据中心集装箱沉到海里

☉FaceBook将数据中心建在北极圈

浸没液冷其实最初是应用在超级计算机上,2012年开始,无论是德国的ISC,还是美国的SC大会,每年都有几家厂商展示全浸没式液冷。直到在SC15上,大量服务器厂商展示浸没液冷概念机,全浸没的时代宣告带来。

国内服务器企业中科曙光、浪潮,以及大名鼎鼎的主板制造商——技嘉,也都早早研究浸没式液冷服务器,尤其中科曙光是国内率先推出液冷服务器的企业,不过部署规模以及公开的服务器密度,不及阿里巴巴。

☉技嘉在2017年展示的液冷服务器样机

此次“浸没式液冷服务器集群”的 PUE值逼近理论极限值1.0,这是一个令人震惊的数值,目前业界多数数据中心的PUE都在1.6左右!PUE1.0的话能够实现非常好的节能环保,保守估计节能情况如下:

依公开资料看,一台液冷服务器功耗600W,一个30万台服务器规模的数据中心集群,如果年均PUE能够从1.25降至1.1,一年节电即可超过2亿度,相当于减少20万吨二氧化碳的排放,如果按每棵树平均每天吸收50克二氧化碳,这相当于1000万颗树一年的二氧化碳吸收量。

为了让大家能够看懂PUE是如何计算的,我把其计算原理介绍下,但我要强调的是,阿里巴巴的PUE计算公式可能出现了进化,可见本小段最后的猜想。

传统PUE计算公式:PUE = 数据中心总设备能耗/IT设备能耗

数据中心总设备主要包含如下4大类:

IT设备(服务器、网络交换机、安全网关等)

制冷系统(空调)

供配电系统(一般指UPS设备,变压器设备)

照明及其它设备(安防设备、消防设备、电梯、传感器以及数据中心管理系统)。

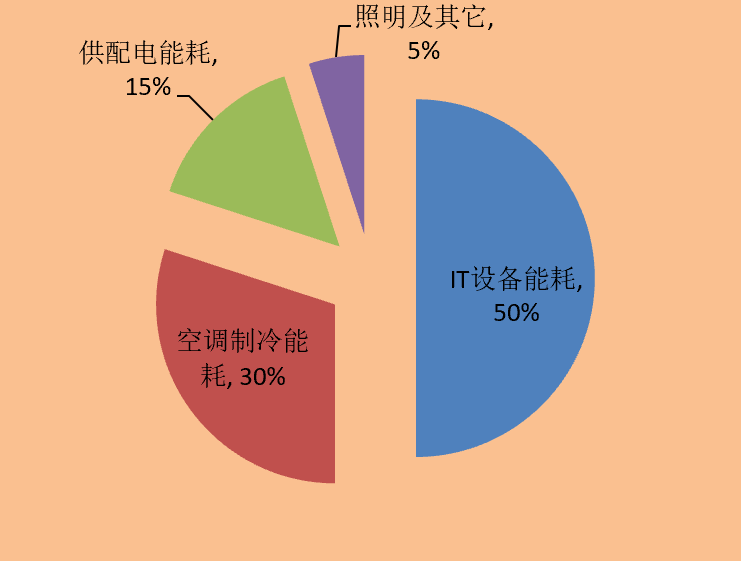

以上设备各自电能消耗占比大概为:

IT设备占50%、空调制冷系统占30%、

供配电系统占15%、照明及其它设备占5%。

☉数据中心设备电能消耗占比

PUE新计算公式的猜想

我大胆猜测一下,浸没式液冷服务器集群PUE逼近1.0的话,原来的PUE公式中分子可能会有变化。

第一个变化是空调制冷系统。在采用了液冷作为媒介散热后,数据中心的空调制冷能耗基本为零。要说明的一点是该空调制冷特指数据中心机房内为服务器散热的,而非办公场所的。

第二个变化是供配电系统。我猜测阿里的工程师做了非常大的改动,将行业常使用的UPS改为市电直供方式。依传统,数据中心主要采用UPS做断电保护,假设UPS实际运行平均效率为91%(其余9%自然消耗掉),以及考虑UPS散热的空调能耗,按数据中心典型PUE为1.7来算,那么UPS环节带来的总能耗达15%(9%X1.7),如果阿里巴巴采用了市电直供方式,这15%能耗直接降为零。

最终原来公式中的数据中心总设备能耗,只剩下了50%的IT设备和5%的照明及其它设备。

采用浸没式液冷服务器后,PUE新公式=IT设备+照明及其它设备/IT设备,最终体现在数字上是:

PUE=50%+5%/50%=1.1

如果阿里又通过太阳能做电量储备用在照明等环境里,5%的数字还会降低。

我个人认为这个PUE新公式适合所有采用浸没式液冷服务器集群的数据中心使用。

TCO变局

TCO (Total Cost of Ownership ),即总拥有成本,包括产品采购到后期使用、维护的成本,在数据中心里,TCO主要由以下两部分组成。

一部分是建设成本(Capex),主要包括土地成本、硬件设备成本(包括IT设备、冷热水管道、变电站等)、园区配套等。通常20%的成本是花费在机房建筑和园区配套建设上,其余80%用在硬件设备上。

第二部分是运营成本(Opex),主要包括人员成本、供电、服务器硬件维护与更换、其它设备维护等。要特别指出的是,在运营成本里,其实有80%以上的花费都用在数据中心供电和制冷上(传统PUE数值里这两项消耗掉45%的能耗)。

在采用液冷服务器后,Opex里的供电与制冷所占的45%能耗将直接节约了。我们假定年电费为1个亿,那么如果省掉UPS(15%电能消耗),光运营成本每年就降低1500万,暂且还没算UPS以及配电设备的投资减少。另外30%制冷电能节省后,1年可节约3000万度电。

除了Capex和Opex两项TCO重要指标外,我们也要回归到液冷服务器本身的质变。

由于液冷服务器无需空调等大型制冷设备,可在任何地方部署,因此大幅节约了数据中心的用地面积,可节省75%以上空间。此外由于服务器内部没有风扇,节省出来的体积可以部署更多CPU,单位体积内的计算能力比过去提升了10倍,也就是计算密度更大了。其实通常情况下,数据中心受到供电、机房承重等因素影响,一个标准机柜均不会在42U的高度里,全部放满服务器。(U是衡量服务器机柜的高度,1u=44.45mm),如下图可以看到右侧服务器上下均有空余空间。

☉某公司数据中心内机柜空间浪费很多

由于采用液体媒介,所以对设备的密闭性也提出了更高要求,而高密封性也使得元器件远离湿度、灰尘、振动的影响,受干扰情况几乎为0;同时,这种特殊液体完全绝缘且无腐蚀性,即使浸没元器件20年以上,成分不会发生任何变化,也不会对电子元器件产生任何影响。

小结

PUE方面:

一座30万台液冷服务器规模的数据中心,年均PUE从1.25降至1.1,一年节电即可超过2亿度,相当于减少20万吨二氧化碳的排放,如果按每棵树平均每天吸收50克二氧化碳,这相当于1000万颗树一年的二氧化碳吸收量。

液冷服务器集群PUE新计算公式:PUE=IT设备+照明及其它设备/IT设备。我暂且猜想阿里巴巴也是采用了这样新的计算方式。

TCO方面:

运营成本(Opex), 假定年电费为1个亿,省掉UPS(15%电能消耗),光运营成本每年就降低1500万,暂且还没算UPS以及配电设备的投资减少。省掉30%制冷消耗,1年可节约3000万度电,同样没有算空调设备的建设成本。

浸没式液冷服务器对产业带来的影响

“摩尔定律正在失效”,是近几年IT研究人员不断提及的事,事实正在演绎随着单位晶圆上集成电路的部署密度逼近极限后(比如2nm后将很难再突破该数据),半导体工艺升级带来的计算性能的提升不能再像以前那么快了(以前是每18个月计算性能翻一倍),每一代制程工艺的研发和成熟需要的时间将越来越长。同时当晶圆面积越来越小、集成电路越来越密集后,IT设备面临巨大的散热、单机功耗挑战。

无论是对于那些善于做高密度服务器的IT企业(单机内提升更多的计算力-Scale up)、以及采用计算资源池化的云计算企业(分布式横向扩展-Scale out),这都是不得不面对的现实难题,而浸没式液冷服务器,从当前看,是可以解决部分上述问题的。

除了上边重点介绍的PUE、TCO带来的巨大变化外,我们还是要回归到浸没式液冷服务器本身的技术创新,解决以下这3个难度很大的业界难题,才能实现集群化部署。

首先是硬件基础设备的定制——不仅仅是服务器产品,未来包括存储、网络等其他IT基础设施都要为全浸没式液冷实现专门的定制化。

其次是高效的管理和运维——在全浸没式液冷系统中,原有的风冷环境管理软件已经完全不适用,从系统监控到维护,都需要有单独开发的软件。因为全浸没式系统是密封结构,所以对于系统内部的液体温度、气压也都需要重新监控,要依赖专门开发的软件来实现。

最后是数据中心的建设——全浸没式液冷的特性在于散热效果好,系统密度高,延迟低。而要实现这些特性,就需要单台系统中尽可能容纳更多的计算、存储节点,进而需要机房承重、供电系统的同步配套。

最终,针对浸没式液冷服务器我们记住四个关键点:

一是PUE的降低、二是TCO成本的降低、三是对摩尔定律难题的解决、四是为实现集群化部署至少解决的3个业界难题。

这样,在摩尔定律全面失效前,人类还能为自己多争取一点时间。

会员用户请加微信,以防失联!

赞

赞

赞

赞